Z-Image-Turbo 文生图模型部署指南

openlab_96bf3613

更新于 1月前

openlab_96bf3613

更新于 1月前

引言

Z-Image-Turbo 是阿里巴巴通义实验室最新发布的高性能文生图模型。它基于先进的 Diffusion Transformer 架构,拥有 60 亿参数,核心特性在于仅需极少的推理步数(通常 8 至 10 步)即可快速生成细节丰富、质感逼真的高质量图像。Z-Image-Turbo 模型非常适配 AI PC 场景,目前已针对搭载 Intel Core Ultra 处理器的平台进行优化,能够充分利用其内置的 CPU 与 GPU 进行高效推理。该模型在以下方面表现卓越:

高效生成:适配显存为 16GB 的消费级硬件,极大降低了使用门槛。

双语渲染:支持在图像中同时渲染英文与中文文本。

精准控制:对复杂的生成提示词(prompt)具备优秀的理解与执行能力。

为了满足不同用户群体的需求,本文提供两套部署方案:

工作流创作者与发烧友:若您希望不通过编程,即可深度控制图像生成的全流程,并自由搭建与调试复杂的生图管线,推荐采用 ComfyUI 方案。该方案通过节点式图形界面,将生图过程解构为可视化模块,为您提供无代码的极致灵活性与流程透明度。

开发人员与工程师:若您需要将模型集成到自有应用、追求极限性能,推荐采用 OpenVINO™ 方案。该方案通过模型转换与硬件级优化,为面向 AI PC 及边缘设备的高性能部署提供完整的工具链支持。

路径一:使用 ComfyUI 快速上手(推荐工作流创作者与发烧友)

该方案通过节点式图形界面,让您无需编程即可自由连接与调试生图流程,实现对生成效果的深度控制。

前置条件:请确保您的系统中已安装并配置好 Conda 环境。

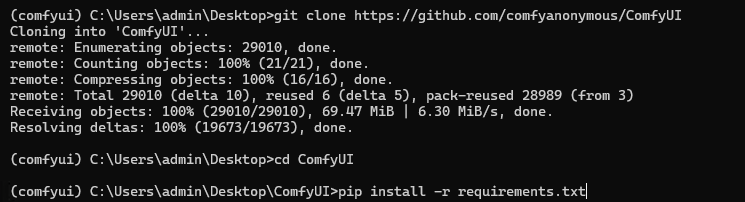

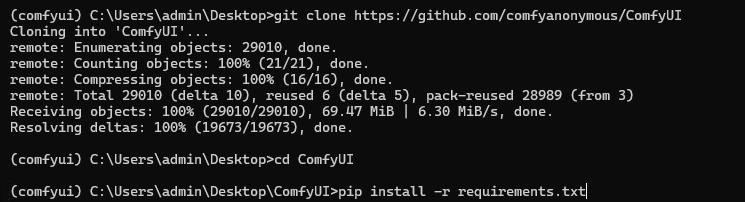

第一步:获取与安装 ComfyUI

通过以下命令克隆官方 ComfyUI 仓库并进行基础环境准备:

cd ComfyUIpip install -r requirements.txt

第二步:Intel GPU Conda Python 环境准备

英特尔 Arc GPU 用户可通过 pip 安装支持 torch.xpu 的 PyTorch 原生版本以启用硬件加速,详细信息可参阅相关技术文档。

安装 PyTorch for XPU 的命令如下:

pip install torch torchvision torchaudio --index-urlhttps://download.pytorch.org/whl/xpu

如需安装包含最新性能改进的 PyTorch XPU nightly 版本,可使用以下命令:

pip install --pre torch torchvision torchaudio --index-urlhttps://download.pytorch.org/whl/nightly/xpu

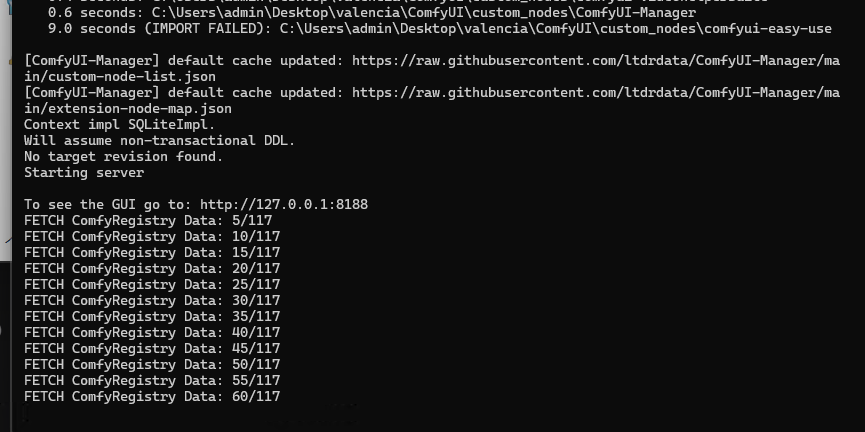

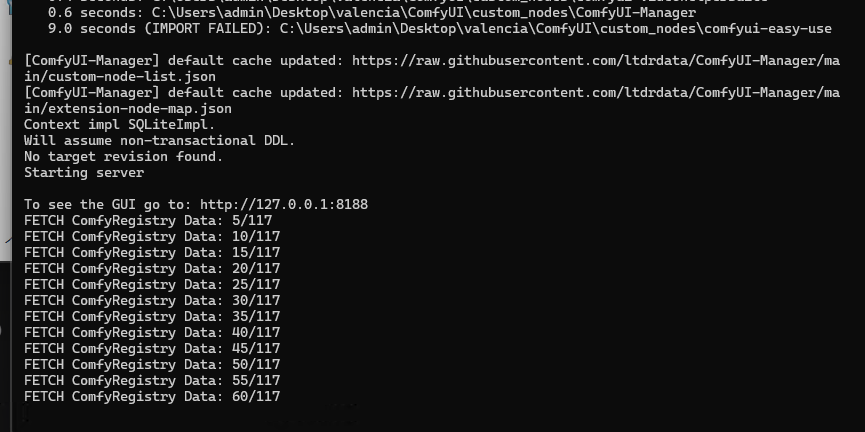

第三步:启动 ComfyUI 图形化界面

在完成上述环境准备后,启动 ComfyUI 本地服务:

第四步:导入模型与工作流

在 ComfyUI 中使用 Z-Image-Turbo 模型,需要分别下载模型文件与预定义的工作流配置。

下载模型文件

访问 ComfyUI 官方中文文档 - Z-Image-Turbo 教程页:https://docs.comfy.org/zh-CN/tutorials/image/z-image/z-image-turbo

导入工作流配置

下载图片后将其拖拽至浏览器中的 ComfyUI 画布区域,系统将自动解析并加载完整的节点工作流配置。随后,您可在对应节点中输入提示词并开始生成图像。

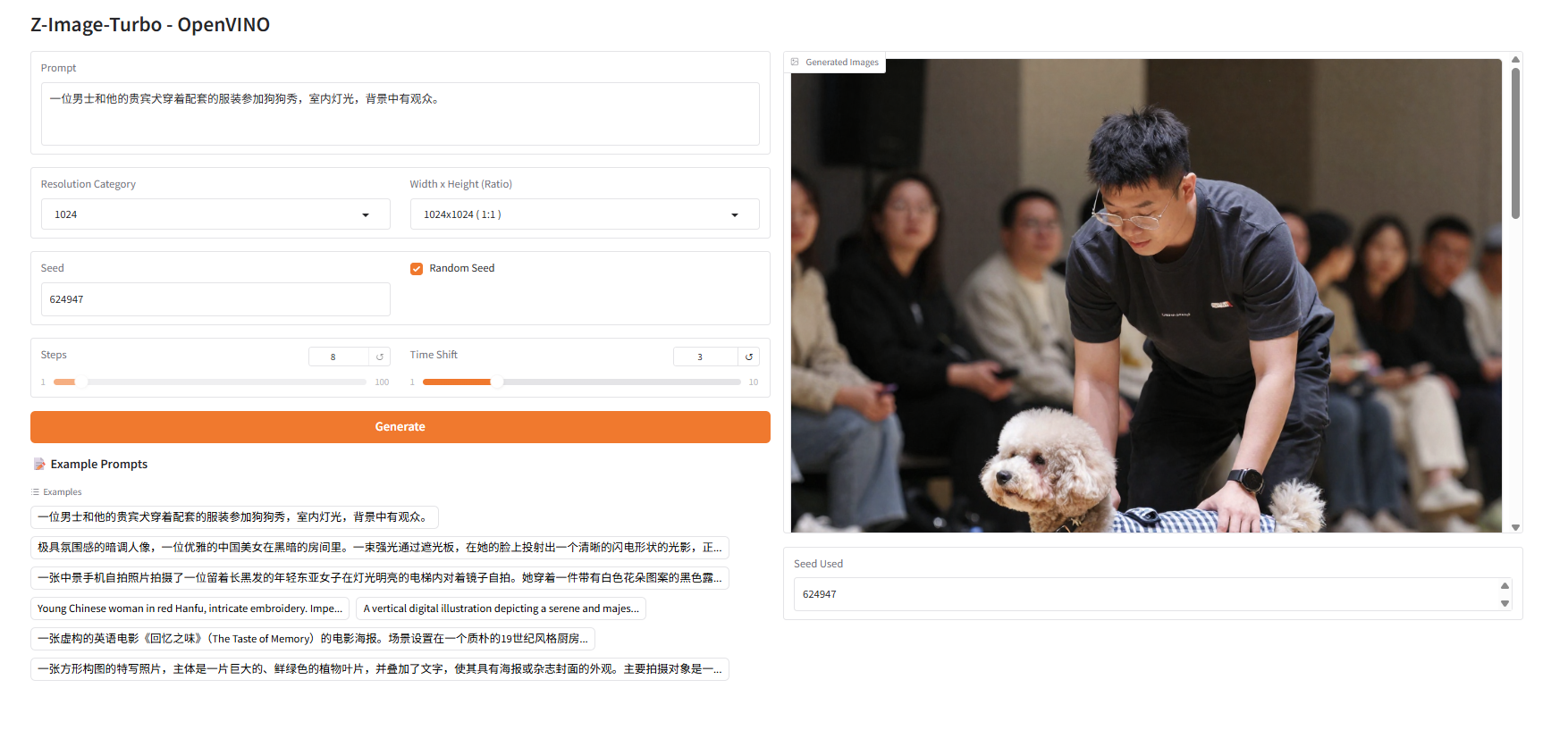

路径二:使用 OpenVINO™进行专业优化与部署(推荐开发人员)

该方案通过模型转换和硬件级优化,为集成部署和性能追求提供专业工具链。

第一步:环境准备

基于以下命令可以完成模型部署任务在 Python 上的环境安装。

python -m venv py_venv./py_venv/Scripts/activate.batpip uninstall -y optimum transformers optimum-intel diffuserspip install git+https://github.com/huggingface/diffuserspip install git+https://github.com/openvino-dev-samples/optimum-intel.git@zimagepip install nncfpip install torch==2.8.0 torchvision==0.23.0 torchaudio==2.8.0 --index-url https://download.pytorch.org/whl/cpupip install openvino==2025.4

第二步:模型下载和转换

在部署模型之前,我们首先需要将原始的 PyTorch 模型转换为 OpenVINO™的 IR 静态图格式,并对其进行压缩,以实现更轻量化的部署和最佳的性能表现。通过 Optimum 提供的命令行工具 optimum-cli,我们可以一键完成模型的格式转换和权重量化任务:

optimum-cli export openvino --model Tongyi-MAI/Z-Image-Turbo --task text-to-image Z-Image-Turbo-ov --weight-format int4 --group-size 64 --ratio 1.0说明:其中 Tongyi-MAI/Z-Image-Turbo 为模型在 HuggingFace 上的 model id, 可用原始模型的本地路径替换;--weight-format int4 --group-size 64 --ratio 1.0 为模型量化参数,如果考虑出图质量,也可以用 --weight-format fp16 替换。

第三步:模型部署与推理

除了利用 Optimum-cli 工具导出 OpenVINO™模型外,我们还在 Optimum-intel 中重构了 Z-Image 模型的 Pipeline,将官方示例示例中的的 ZImagePipeline 替换为 OVZImagePipeline 便可快速利用 OpenVINO™进行模型部署,完整示例可参考以下代码流程。

import torchfrom optimum.intel import OVZImagePipeline# 1. Load the pipelinepipe = OVZImagePipeline.from_pretrained("Z-Image-Turbo-ov", device="cpu")prompt = "Young Chinese woman in red Hanfu, intricate embroidery. Impeccable makeup, red floral forehead pattern. Elaborate high bun, golden phoenix headdress, red flower****eads. Holds round folding fan with lady, tree****ird. Neon lightning-bolt lamp (⚡️), bright yellow glow, above extended left palm. Soft-lit outdoor night background, silhouetted tiered pagoda (西安大雁塔), blurred colorful distant lights."# 2. Generate Imageimage = pipe(prompt=prompt,height=512,width=512,num_inference_steps=9, # This actually results in 8 DiT forwardsguidance_scale=0.0, # Guidance should be 0 for the Turbo modelsgenerator=torch.Generator("cpu").manual_seed(42),).images[0]image.save("example_zimage_ov.png")

生图结果如下:

总结

本文针对通义 Z-Image-Turbo 模型,提供了从个人创作到生产部署的完整路径。

对于希望零代码快速体验 AIGC 创作的工作流创作者与发烧友,ComfyUI 方案提供节点式图形界面通过自由连接与调试生图流程,让您无需编程即可自由连接与调试生图流程,是实现创意和深度控制的理想工具。

对于需要将模型集成到产品中的开发人员,OpenVINO™ 方案通过硬件级优化,为模型带来了显著的性能提升。作为轻量化高效模型的代表,Z-Image-Turbo 结合 OpenVINO™,能够充分发挥 Intel CPU/GPU 的算力,非常适合高性能、低延迟的生产环境推理部署。

参考资料

[Z-Image-Turbo 模型卡片](https://huggingface.co/Tongyi-MAI/Z-Image-Turbo)

[OpenVINO™官方文档](https://docs.openvino.ai/)

[Optimum Intel GitHub](https://github.com/huggingface/optimum-intel)

[Diffusers 库文档](https://huggingface.co/docs/diffusers/)

本文作者:许紫妍 杨亦诚

OpenVINO 小助手微信 : OpenVINO-China

如需咨询或交流相关信息,欢迎添加 OpenVINO 小助手微信,加入专属社群,与技术专家实时沟通互动。