DevCon 直播回顾:基于 Intel AI PC 与 OpenVINO™,重塑本地 AI 的开发方式

openlab_96bf3613

更新于 2月前

openlab_96bf3613

更新于 2月前

过去几年,生成式 AI 的发展速度超乎想象。无论是文本生成、图像生成、多模态对话,还是 AI Agent,它们都在迅速从实验室走向真实的产品形态。然而,在云端运行一切并不是开发者的长期理想:延迟、成本、隐私、部署复杂度…… 这些问题不断推动行业向一个方向迁移 —— 本地 AI(On-device AI)。

要让本地 AI 真正落地,光有 “大模型” 是不够的;更重要的是硬件能力、推理性能、模型优化、系统接口之间的协作。在这方面,Intel® AI PC 与 OpenVINO™ 构成了一个非常成熟的组合,而 Windows AI Foundry 则为整个生态提供了统一的入口与打包方式。

本次直播中我们从开发者视角,全面理解 “AI PC + OpenVINO™ + Windows AI Foundry” 意味着什么,以及它如何让你的生成式 AI 应用在本地运行得更快、更稳、更省成本。

一、AI PC:从硬件层面改变本地 AI 的能力边界

AI PC 不只是一台 “能跑大模型” 的电脑,它更像是一台面向本地 AI 优化的异构计算平台。

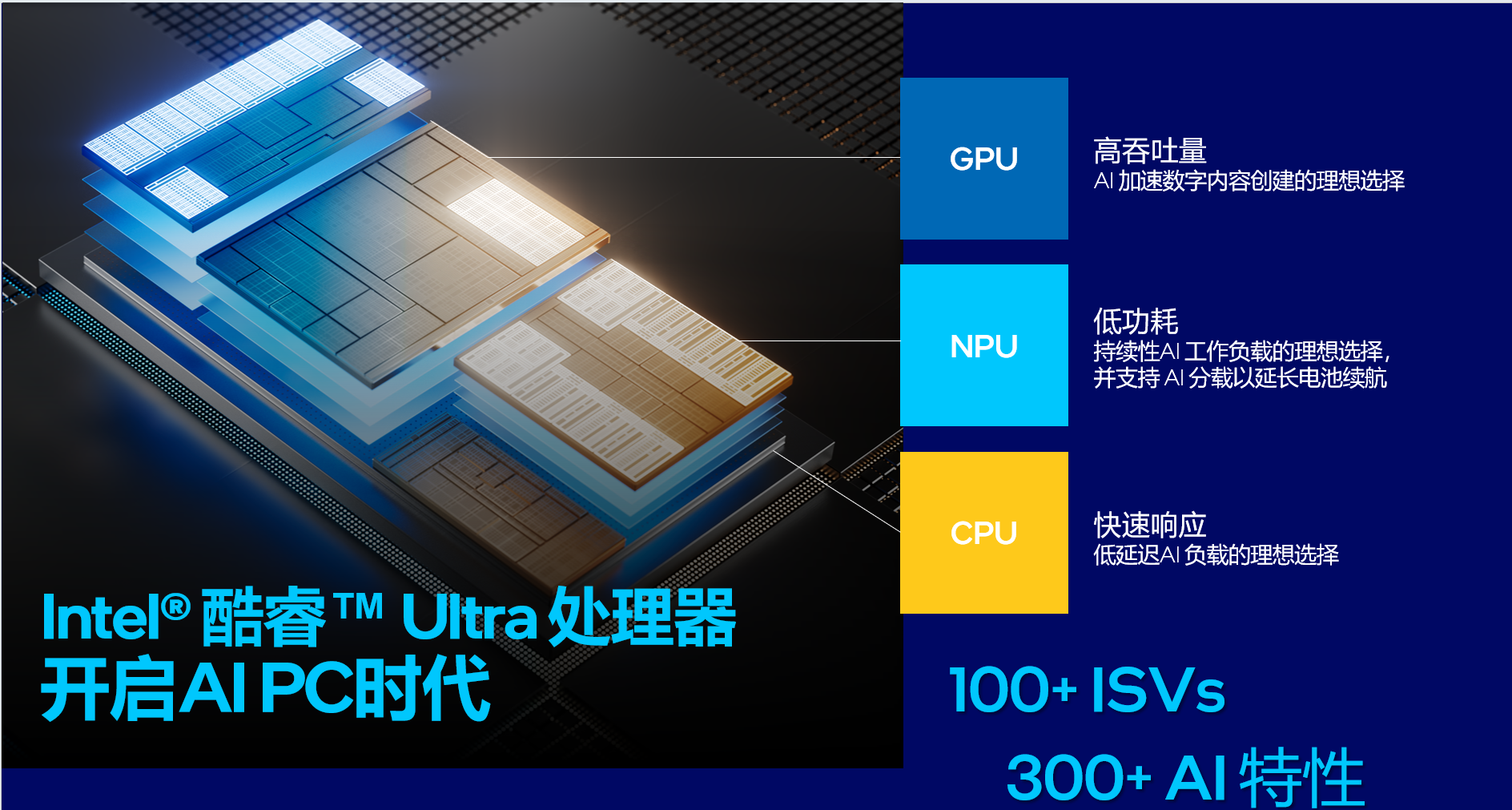

在 Intel® Core™ Ultra 处理器中,CPU、GPU 与 NPU 三个计算单元各司其职,但又协同工作,共同组成了一套完整的 xPU 架构。

1.CPU:通用高性能处理器

它始终是系统中最灵活的计算单元,适合需要逻辑控制、复杂运算和串行任务的 AI 模块。LLM 的部分权重、前后处理等逻辑往往仍需要 CPU 来高效执行。

2.GPU:高吞吐生成引擎

对于 Stable Diffusion、图像生成、编码解码、并行矩阵计算等任务,GPU 提供极高吞吐,加速效果非常突出。

3.NPU:能耗极低的持续 AI 执行单元

NPU 的意义不是 “更快”,而是 “更省”。对那些需要长时间运行的 AI 任务(如实时字幕、图像背景分离、语音识别等),NPU 能显著降低功耗,让 AI 在后台持续运行成为可能。

结合起来,AI PC 的能力不仅是更强,而是更加 “适合 AI”。

二、OpenVINO™:让 AI PC 的全部潜力释放出来

如果说硬件是基础,那么 OpenVINO™ 就是把硬件 “变成生产力” 的软件核心。

开发者常见的痛点包括:

而 OpenVINO™ 解决这些问题的方式并不是 “某一个独特功能”,而是它整体的设计理念:

用一个引擎、一个工具链、一个优化系统,贯穿从模型获取、模型优化到推理部署的全流程。

在 AI PC 上,OpenVINO™ 提供了三大关键能力:

1. 高性能模型优化(INT8/INT4、图优化、KV Cache 优化)

OpenVINO™ 内置的量化工具(如 NNCF)可以将 LLM 权重量化到 INT4 或 INT8,让模型在不影响体验的前提下大幅减少大小、降低运行成本。

对于生成式 AI,OpenVINO™ 还在持续优化 KV Cache,让长上下文推理速度显著加快。

2. 跨 CPU/GPU/NPU 的统一推理接口

开发者无需关心模型应该跑在哪种设备上 ——OpenVINO™ 会根据任务特点自动选择最优路径,并且兼容 Windows ML 与 Foundry API 的自动调度。

3. 全生态支持:Hugging Face、ONNX、PyTorch、SD、Whisper、YOLO…

几乎市面上主流模型都能通过 OpenVINO™ 在 AI PC 上获得高性能推理体验。

开发者不需要为硬件写代码,OpenVINO™ 会自动帮你把模型跑快。

三、Windows AI Foundry:统一接口,但真正的加速来自 OpenVINO™

很多开发者在听到 Windows AI Foundry 时,会误以为它是一个 “新的推理引擎”。事实上,Foundry 更像是 Windows 提供的统一 AI 入口,而不是替代 OpenVINO™ 的方案。

它的重要意义在于:

在 Intel AI PC 上,Windows ML 默认启用 OpenVINO™ 加速。

Windows ML + OpenVINO™ Execution Provider(EP)是整个本地 AI 的核心组合。

换句话说,Foundry/Windows ML 负责 “入口”,OpenVINO™ 负责 “加速”。

你写的应用可能是这样的:

Your App → Windows ML → OpenVINO™ EP → Intel Hardware

但你只需要写 “Your App”,后面的路径 Windows + OpenVINO™ 已经替你自动处理。

因此,开发者在使用 Windows AI Foundry 时,本质上是在 “以 Windows 的方式调用 OpenVINO™ 的加速能力”。

这对于部署模型到数亿台 Windows PC 来说意义重大。

四、为什么 “AI PC+OpenVINO™+Foundry” 是开发者的理想组合?

一个本地 AI 应用通常需要同时具备:

单独一个工具很难做到全部,而这套组合却刚好能覆盖全部需求:

- AI PC 提供硬件底座

三大异构引擎让本地 AI 具有真正的可执行能力,而不仅仅是 “能跑”。

- OpenVINO™ 释放硬件潜能

自动优化、自动调度、自动量化,让同样的模型在 AI PC 上跑得更快、更省。

- Windows AI Foundry 提供一致的开发体验

你只需要 “像写一个正常 Windows 应用那样” 开发,底层会自动选用 OpenVINO™。

对于开发者来说,是一个极其有吸引力的技术组合。

五、推荐给开发者的资源(快速上手与进阶)

欢迎开发者查询以下开源资源:

Windows AI Foundry 集成 OpenVINO™示例代码 https://github.com/intel/Microsoft-Build2025-Samples

Windows AI APIshttps://learn.microsoft.com/en-us/windows/ai/apis/

Foundry Local 文档 https://learn.microsoft.com/en-us/azure/ai-foundry/foundry-local/

OpenVINO™ Notebooks(190+ 示例)https://github.com/openvinotoolkit/openvino_notebooks

Windows ML × OpenVINO™示例代码 https://github.com/intel/Microsoft-Build2025-Samples

写在最后:本地 AI 的时代真正来了

生成式 AI 正在快速从 “云端依赖” 走向 “本地智能”。 AI PC 让硬件准备好了; OpenVINO™ 让模型跑快了; Windows AI Foundry 让系统接口变得统一、易打包、易部署。

它们共同构成一条为开发者精心铺设的道路:

让 AI 在你的 PC 上运行得简单、便宜、稳定、强大。

未来的 AI 应用,不再依赖 “云 + API key”,而将更多运行在我们每天使用的 PC 上。

如果你也在构建下一代 AI 应用,那么现在就是上车的最佳时机。

直播回放

方式一 注册网站 “OpenVINO™ Windows ML 赋能 AI 端侧落地” 可观看回放并下载相关资料

方式二 点击链接查看 B 站回放:https://www.bilibili.com/video/BV1mcCvBDEht/