在英特尔®硬件上部署深度学习模型的无代码方法 关于 OpenVINO™ 深度学习工作台的三部分系列 第一部

openlab_4276841a

更新于 3年前

openlab_4276841a

更新于 3年前

作者 Taylor, Mary, 翻译 李翊玮

关于 OpenVINO™ 深度学习工作台的三部分系列文章

关于该系列

· 了解如何转换、微调和打包 推理就绪的 TensorFlow 模型,该模型针对英特尔®硬件进行了优化,仅使用 Web 浏览器。每一步都在云中使用 OpenVINO™ 深度学习工作台和 Intel® DevCloud for the Edge 进行。

· 第一部分:我们向您展示英特尔®深度学习推理工具及其工作原理的基础知识。

· 第二部分(此文):我们使用OpenVINO深度学习工作**成导入,转换和基准测试TensorFlow模型的每个步骤。

· 第三部分:我们向您展示如何更改精度级别以提高性能,以及如何使用OpenVINO深度学习工作台仅使用浏览器导出随时可运行的推理包。

第一部分:面向深度学习推理部署的英特尔®工具

了解 OpenVINO™ 深度学习工作台和面向边缘的英特尔® DevCloud 的基础知识

修剪深度学习模型,组合网络层,针对多个硬件目标进行开发 - 从经过训练的深度学习模型到随时可以部署的推理模型似乎是一项繁重的工作,如果您手动编写代码,则可以完成这些工作。

借助英特尔®工具,您可以完全在线地从经过训练的模型转到经过优化的打包推理模型,而无需编写一行代码。在本文中,我们将向您介绍用于深度学习部署的英特尔®工具包,包括英特尔® OpenVINO™ 工具包分发版和深度学习工作台。之后,我们将为您注册免费的面向边缘的英特尔 DevCloud 帐户,以便您可以开始优化自己的推理模型。

什么是深度学习模型,部署如何在英特尔硬件上工作?

深度学习有两个大阶段:训练和推理。在训练期间,计算机通过分析数千个输入(图像、句子、声音)并猜测它们的含义来构建人工神经网络模型。反馈回路告诉机器猜测是对还是错。这个过程重复了数千次,创建了一个多层算法网络。一旦网络达到其目标精度,就可以将其冻结并导出为训练模型。

在深度学习推理期间,设备将传入的数据与经过训练的模型进行比较,并推断数据的含义。例如,智能相机将视频帧与深度学习模型进行比较,以进行对象检测。然后它推断出一个形状是猫,另一个是狗,第三个是汽车,依此类推。在推理过程中,设备没有学习;它正在识别和解释它接收到的数据。

有许多流行的框架,如TensorFlow,PyTorch,MXNet,PaddlePaddle,以及众多深度学习拓扑和训练模型。每个框架和模型都有自己的语法、层和算法。要在英特尔 CPU、集成 GPU 或英特尔®® Movidius™ VPU 上运行深度学习模型,我们需要:

1. 优化模型,使其尽可能快地运行

2. 将其转换为中间文件(IR 文件),该文件将在任何英特尔硬件组合上运行

3. 调整它,使其在性能和准确性之间取得适当的平衡

4. 将其打包为完整的推理模型,随时可以部署

你是怎么做到的?您需要数据科学学位吗?不。您所需要的只是 OpenVINO 深度学习工作台。

优化|转换为 IR 文件|调谐|打包和部署

使用浏览器部署深度学习模型:OpenVINO 深度学习工作台

深度学习工作台可让您在基于 Web 的界面中访问 OpenVINO™ 工具套件,包括模型下载器、模型优化器、训练后优化工具、准确性检查器和基准测试工具.借助深度学习工作台,您可以指向并单击从经过训练的模型到经过测试和优化的应用程序包。

深度学习工作台面向谁?

除了你,你的意思是,对吧?我们为两种基本类型的开发人员构建了深度学习工作台和DevCloud:初学者,特别是AI部署的初学者,以及需要尽可能快速,轻松地将AI投入生产的在职专业人员。

深度学习工作台简化了模型导入、调优和部署。

如果您是初学者

请注册 DevCloud 并按照自己的方式学习教程和参考实现。然后,使用深度学习工作台创建您的第一个优化推理模型。您可以尝试不同的优化,并查看您的模型如何在各种不同的英特尔硬件和加速器上运行。

如果您是专业人士

请使用 DevCloud 和深度学习工作台来转换预训练的模型,然后系统地进行基准测试、测试和调整。您可以构建可在任何现代英特尔®芯片上运行的生产就绪型深度学习推理应用。您不必购买工作台硬件或成为数据科学家即可做到这一点。

在最新的英特尔硬件上进行测试和调整 , 无需购买任何硬件!

您可以在本地计算机上运行深度学习工作台,但这意味着您只能在设备上进行测试和部署。我们为您提供了一个更好、更免费的测试平台:Intel DevCloud for the Edge.DevCloud 是一个在线沙盒,您可以在 JupyterLab 环境中的一系列英特尔硬件上运行深度学习工作台。

您可以在面向边缘的英特尔 DevCloud 上免费执行的五件事

1. 了解英特尔硬件上的深度学习推理。

2. 探索深度学习推理中间件和参考应用。

3. 使用英特尔® OpenVINO™ 工具包分发版创建您自己的 JupyterLab 笔记本并在线构建应用程序。

4. 在最新的英特尔硬件上测试您的应用,包括来自英特尔生态系统合作伙伴的计算机。

5. 运行 OpenVINO 深度学习工作台,从经过训练的模型转变为经过优化、随时可部署的推理模型,无需代码。

免费访问面向边缘的英特尔® DevCloud 上的英特尔®硬件和深度学习工作台。

让我们开始吧 — 如何启动 OpenVINO 深度学习工作台

如果您还没有帐户,请通过接受英特尔的条款和条件以及隐私政策来注册 DevCloud for the Edge。继续。它是免费的,只需要几分钟。拥有帐户后,请登录。

注意:为获得最佳效果,请使用 Google Chrome 访问 Intel DevCloud for the Edge.转到“优化”选项卡,然后选择“深度学习工作台”。

登录后,从“优化”选项卡启动深度学习工作台。

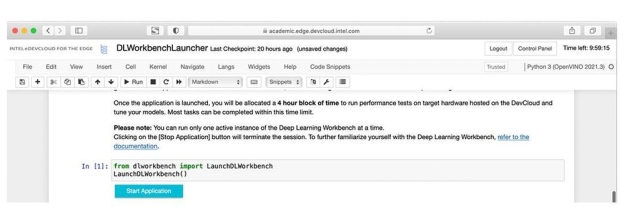

在JupyterLab中打开一个新的笔记本,其中包含一个单元格供您运行。不用担心!这是您将看到的唯一代码。将光标放在单元格中,然后单击菜单栏中的“运行”按钮。“开始”按钮将出现在单元格下方。单击“开始应用程序”,您就可以上路了。

启动器在JupyterLab中运行后,运行第一个单元格,然后单击“启动应用程序”。

下一步 - 第二部分:使用 OpenVINO™ 深度学习在英特尔硬件上导入、转换 TensorFlow* 模型并进行基准测试。

在下一篇文章中,我们将向您展示如何通过六个简单的步骤创建新项目并导入 TensorFlow 模型并进行基准测试。